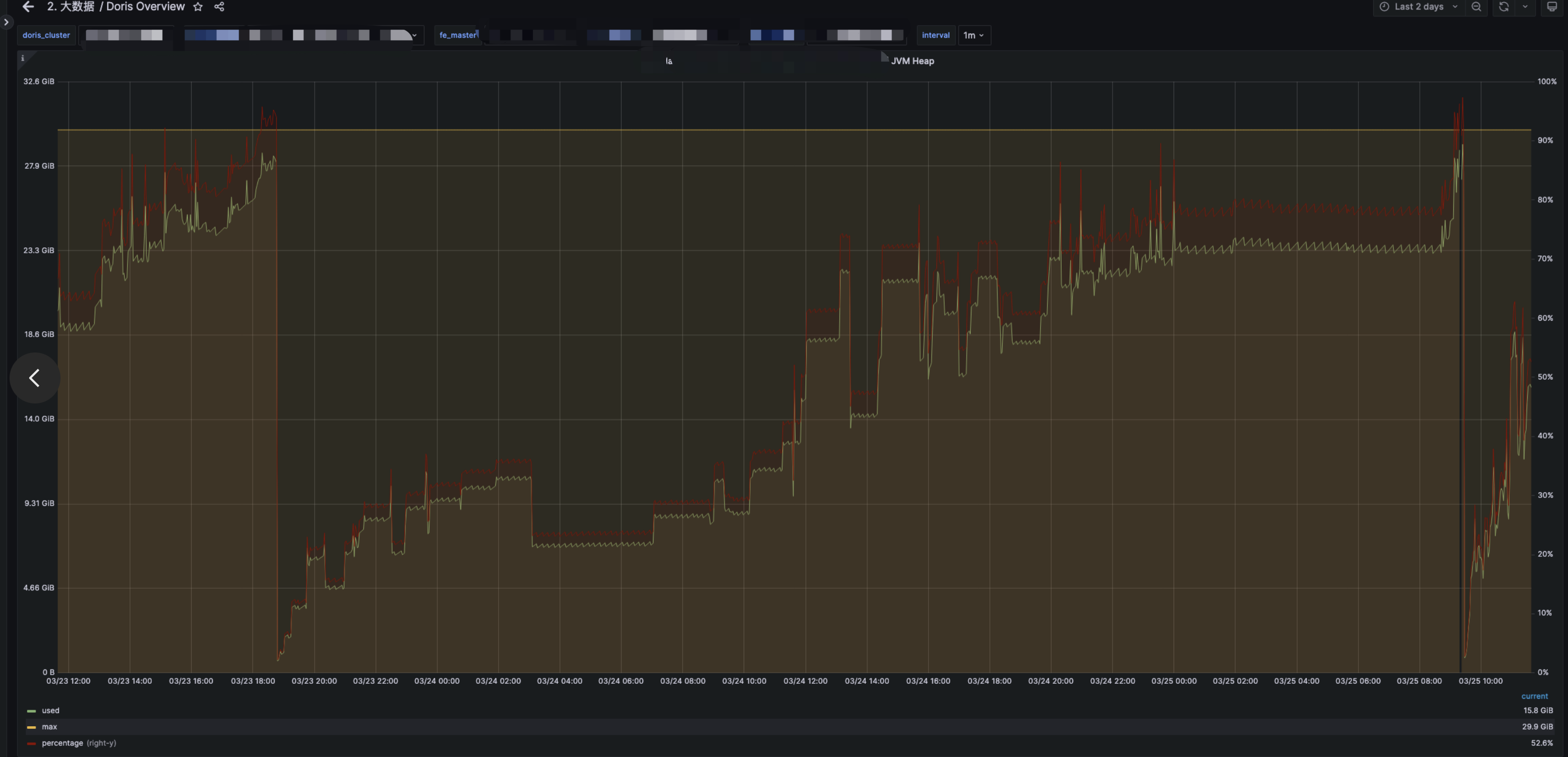

1、现象

目前这个集群只用于sql查询hive通过catalog的方式,没有写入。fe的内存现在已经调整到30g,目前只能通过重启的方式。

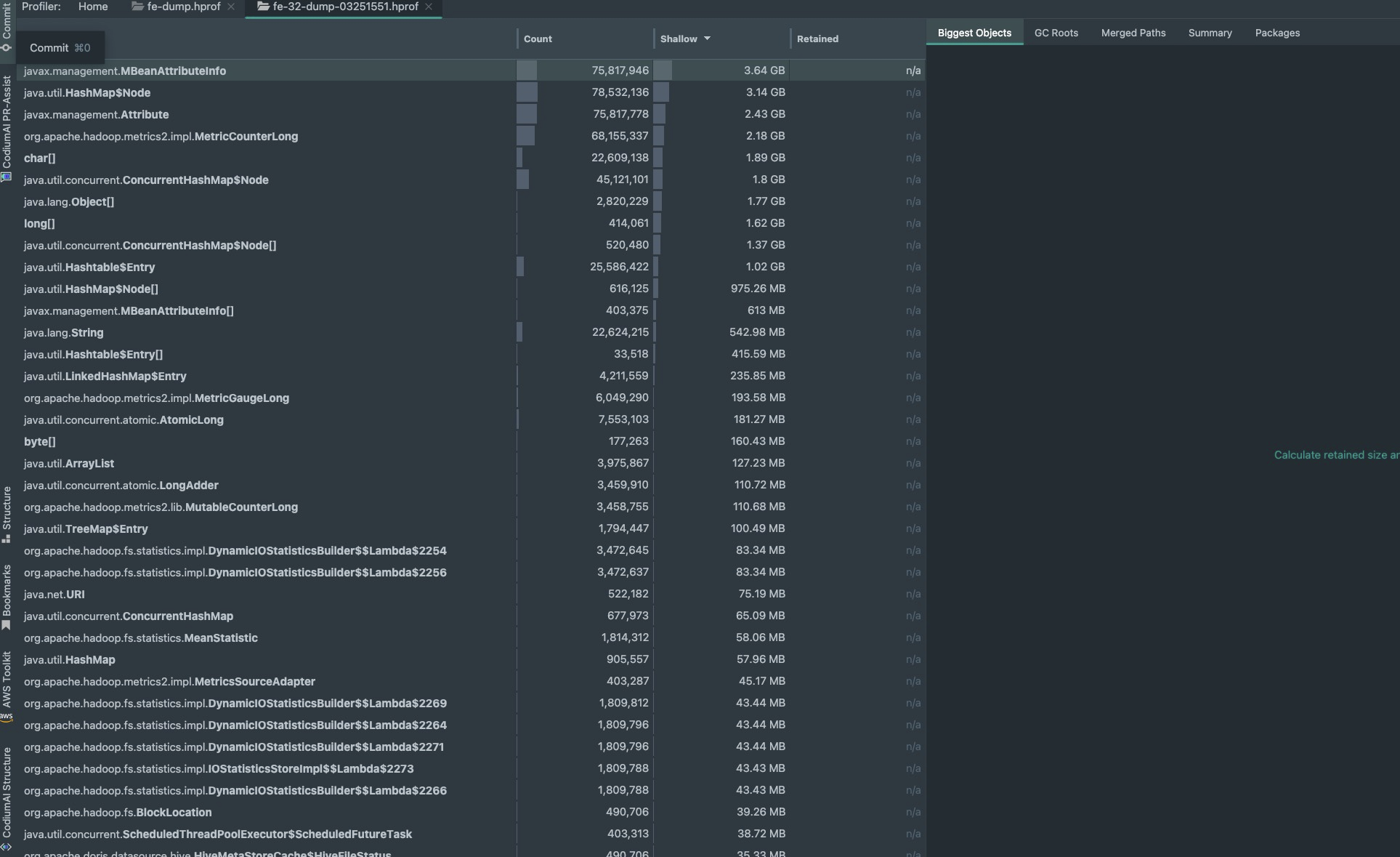

2、这个是jmap dump下来的信息

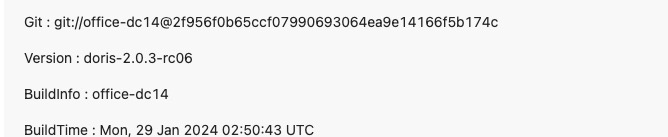

3、doris版本

4、监控是通过 prometheus取获取这块的监控的

curl http://fe_host:http_port/metrics

curl http://be_host:webserver_port/metrics

5、fe的配置

LOG_DIR = ${DORIS_HOME}/log

DATE = `date +%Y%m%d-%H%M%S`

JAVA_OPTS="-Xmx30720m -XX:+UseMembar -XX:SurvivorRatio=8 -XX:MaxTenuringThreshold=7 -XX:+PrintGCDateStamps -XX:+PrintGCDetails -XX:+UseConcMarkSweepGC -XX:+UseParNewGC -XX:+CMSClassUnloadingEnabled -XX:-CMSParallelRemarkEnabled -XX:CMSInitiatingOccupancyFraction=80 -XX:SoftRefLRUPolicyMSPerMB=0 -Xloggc:$DORIS_HOME/log/fe.gc.log.$DATE"

JAVA_OPTS_FOR_JDK_9="-Xmx30720m -XX:SurvivorRatio=8 -XX:MaxTenuringThreshold=7 -XX:+CMSClassUnloadingEnabled -XX:-CMSParallelRemarkEnabled -XX:CMSInitiatingOccupancyFraction=80 -XX:SoftRefLRUPolicyMSPerMB=0 -Xlog:gc*:$DORIS_HOME/log/fe.gc.log.$DATE:time"

sys_log_level = INFO

http_port = 8030

rpc_port = 9020

query_port = 9030

edit_log_port = 9010

mysql_service_nio_enabled = true

priority_networks = xx.xx.xx.xx/20

enable_spark_load=true

spark_load_default_timeout_second=259200