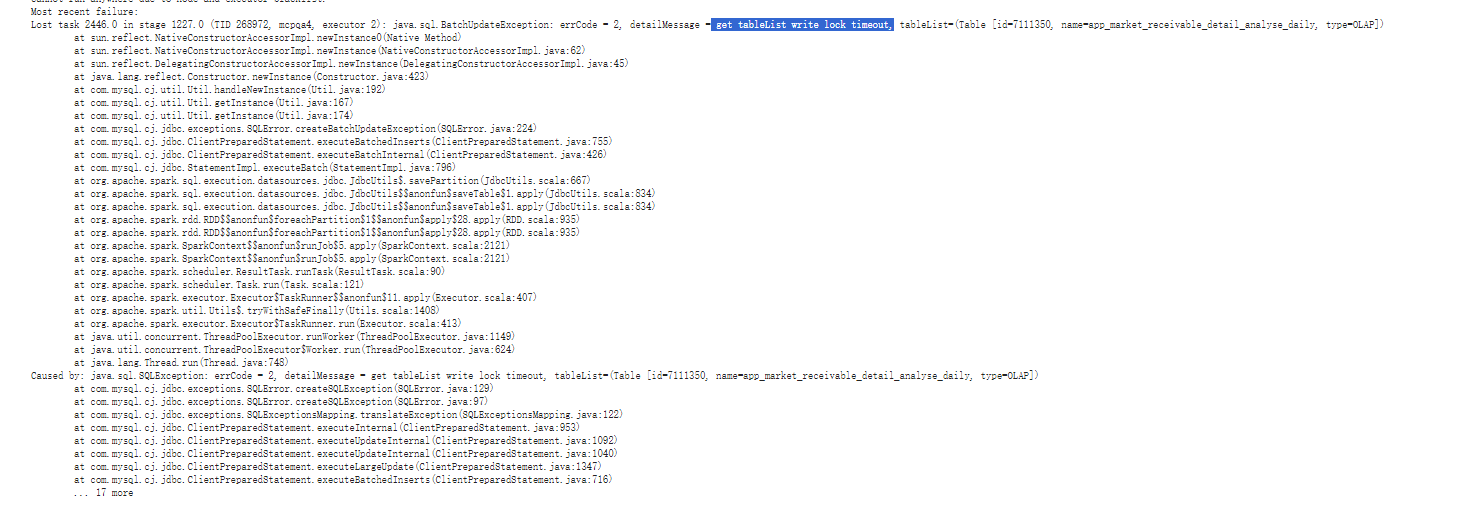

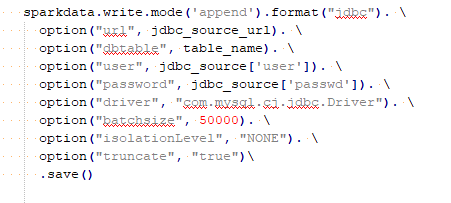

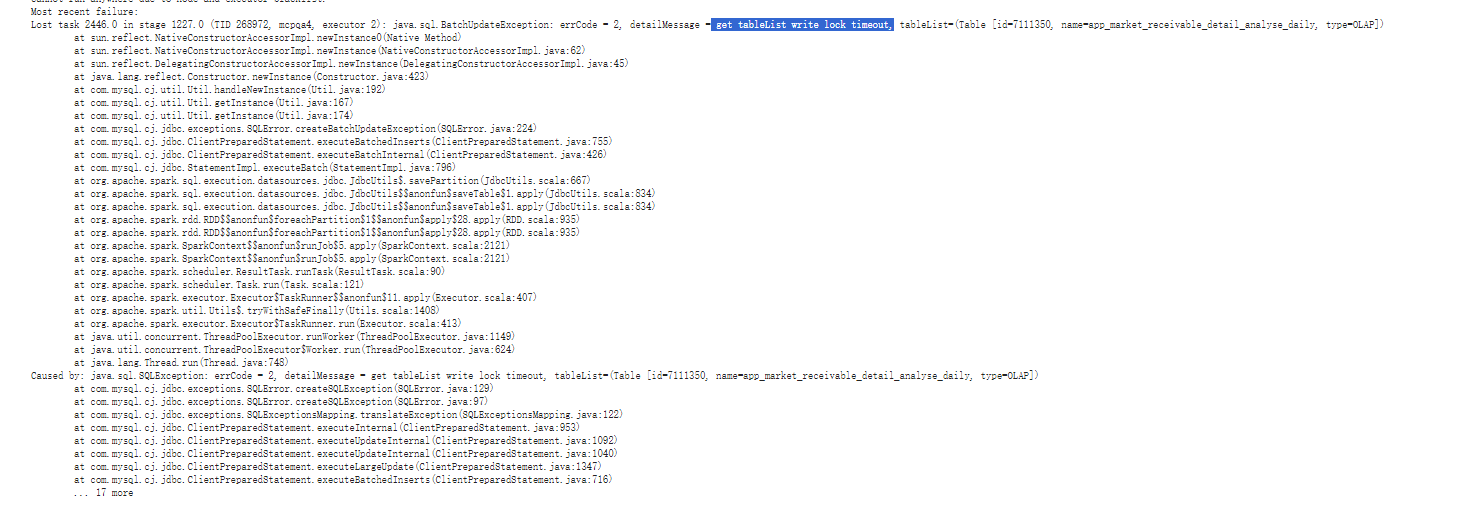

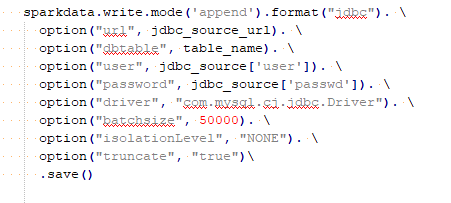

url且已添加rewriteBatchedStatements=true 参数

url且已添加rewriteBatchedStatements=true 参数

1,通常是因为FE JVM内存设置太小,或者FE/BE混布导致的

2. 出现该异常时,单独打一个 jstack,联系社区同学具体分析:

jstack -l pid > 1.js

具体可以查阅Doris论坛帖子:

https://ask.selectdb.com/questions/D1O5/doris-2-0-4-get-tablelist-write-lock-timeout

为更具体地了解问题(处理后会更新回帖),可以➕我一下W:yz-jayhua